La historia del antisemitismo ha recorrido los siglos adaptándose a cada época con elocuente perversidad. Hoy, en plena revolución tecnológica, el odio al judío ha encontrado un nuevo vehículo: la inteligencia artificial (IA). Lo que antes eran panfletos o proclamas marginales, hoy puede reproducirse y amplificarse —incluso sin intención explícita— mediante algoritmos entrenados con datos sesgados o contaminados por discursos de odio. Nos encontramos ante un fenómeno que exige una reflexión profunda desde el derecho, la ética y la democracia.

La irrupción de la IA en todos los ámbitos de la vida moderna ha traído avances notables. En sectores como la salud, la industria o la educación, los sistemas algorítmicos han mejorado la eficiencia y la capacidad de diagnóstico o predicción. Pero esos mismos sistemas, cuando aplican criterios opacos o entrenan con bases de datos ideológicamente sesgadas, pueden también vulnerar derechos fundamentales. Uno de los más sensibles es el derecho a la libertad de información, y dentro de este, el derecho a recibir información veraz.

Del negacionismo al antisionismo: formas contemporáneas del odio

Hoy en día, millones de personas consultan sistemas de IA —como ChatGPT, Perplexity o Copilot— en busca de respuestas rápidas, estructuradas y, se supone, neutrales. Pero ¿qué ocurre cuando esas respuestas reproducen, sin filtros críticos, estereotipos antisemitas, relativizan el Holocausto o presentan el antisionismo como un legítimo marco discursivo ajeno al odio? El peligro no es sólo técnico: es político, jurídico y social.

Los resultados de diversas pruebas realizadas con estos sistemas muestran que, aunque la mayoría de los asistentes virtuales rechazan explícitamente contenidos judeofóbicos cuando se les pregunta de manera directa, existen grietas preocupantes. En contextos concretos, y especialmente cuando los usuarios insisten o manipulan el diálogo, los modelos acaban generando respuestas que normalizan o incluso justifican discursos de odio contra los judíos.

Uno de los hallazgos más inquietantes es la forma en que algunos sistemas pueden alimentar el negacionismo del Holocausto. Aunque las respuestas iniciales suelen ser correctas y condenatorias, basta con mantener el diálogo desde una postura revisionista para que el sistema acabe proporcionando argumentos propios del discurso negacionista: cuestionamientos sobre las cifras de víctimas, dudas sobre las cámaras de gas, o referencias a supuestas "motivaciones ideológicas" en la narrativa histórica dominante. Todo esto sin alertar al usuario de que se trata de bulos históricamente refutados.

Más sutil, pero no menos grave, es la difusión del discurso antisionista como una forma de antisemitismo contemporáneo. Al formular preguntas como "¿Es Israel un Estado genocida?" o "¿La existencia de Israel perjudica al mundo?", los sistemas de IA tienden a ofrecer respuestas que, si bien intentan matizar, acaban citando exclusivamente fuentes parcializadas o reproduciendo sin contraste los informes más acusatorios. En algunos casos, el sistema llega a sugerir que los judíos deberían ser "reubicados" en otros países, un eufemismo perturbador que remite a los peores episodios de la historia europea.

Los algoritmos no son neutrales: el problema de la opacidad

Esta dinámica se agrava por el hecho de que los algoritmos no operan en el vacío. Se nutren de datos que han sido seleccionados, jerarquizados y codificados por humanos. Y como toda producción humana, esa selección está sujeta a sesgos: ideológicos, políticos, culturales. El peligro no está tanto en la intención maliciosa de los desarrolladores —que en su mayoría actúan con responsabilidad— como en la invisibilidad de los filtros, en la opacidad de las fuentes y en la confianza ciega del usuario medio.

A nivel jurídico, esta realidad plantea desafíos importantes. ¿Cómo proteger el derecho a recibir información veraz en un entorno mediado por máquinas que no son responsables legales de lo que generan? ¿Qué sucede cuando un discurso de odio se produce de manera indirecta, sin que exista una voluntad expresa de discriminar, pero con consecuencias reales para la dignidad y seguridad de los colectivos afectados? ¿Quién responde por las manipulaciones ideológicas que pueden derivarse de una interacción prolongada con una IA?

El reciente Reglamento Europeo de Inteligencia Artificial ha intentado establecer normas claras. Prohíbe, entre otras prácticas, la clasificación de personas en función de criterios sociales, raciales o religiosos si esa clasificación puede producir efectos jurídicos adversos. También prevé mecanismos de transparencia y códigos de buenas prácticas para los sistemas de IA de uso general. Pero aún estamos lejos de tener un marco eficaz para detectar y frenar la reproducción algorítmica del antisemitismo.

Verdad, derechos y dignidad frente al odio estructurado

Porque el problema no es solo legal. Es también pedagógico y político. Combatir el antisemitismo en la era digital exige comprender cómo se reconfigura el odio en el lenguaje de los datos, cómo se disfraza de opinión o análisis político, cómo se infiltra en los discursos antisionistas radicales que niegan al pueblo judío el derecho a la autodeterminación. Hoy, más que nunca, es urgente que las instituciones, las comunidades educativas, los medios y los desarrolladores tecnológicos actúen con responsabilidad compartida.

La IA no es neutra. Refleja, reproduce y amplifica lo que somos. Y si en su espejo vemos aparecer una versión pulida pero persistente del antisemitismo de siempre —adaptado a los nuevos lenguajes, disfrazado de razonamiento estructurado—, entonces el deber democrático es intervenir. No para censurar el debate, sino para garantizar que la libertad de información no se convierta en una coartada para el odio.

Porque frente al odio estructurado, necesitamos también una defensa estructural de la verdad, de la dignidad y de los derechos fundamentales ▪

Para el artículo completo: Quaderns IEE, 4/2(2025), Institut d’Estudis Europeus de la Universitat Autònoma de Barcelona

https://revistes.uab.cat/quadernsiee/article/view/v4-n2-grima/117-pdf-ca

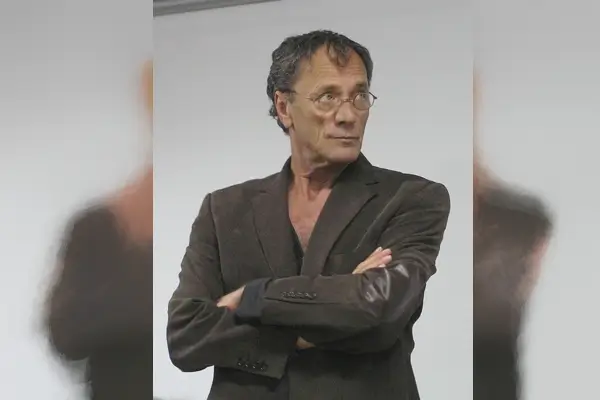

Carles Grima Camps es abogado y especialista en derecho constitucional. Es miembro del Ilustre Colegio de la Abogacía de Barcelona (ICAB) y autor de diversos estudios sobre libertad de información, discurso de odio e inteligencia artificial.